VMware Tanzu デプロイしてみた② コンテンツライブラリの作成

前回までの記事は以下から参照頂けます。

事前準備編

NSX-T 3.0 Tier0、Tier1ゲートウェイの作成、テナントネットワークの作成

TANZUデプロイ編

VMware Tanzu デプロイしてみた① ワークロード管理の有効化から名前空間の作成

今回はTanzu Kubernetesを利用するのに必要なコンテンツライブラリを作成します。

Tanzu Kubernetesクラスタをサポートするにはコンテンツライブラリの構成が必要な様です。Kubernetesのworker VM等のOVF File等をコンテンツライブラリから同期する目的で利用するのでしょう。

さっそくコンテンツライブラリを作成しましょう。

コンテンツライブラリ作成項目から「作成」をクリックします。

任意で「名前」を入力し、「NEXT」をクリックします。

私の環境はvCenterからインターネットアクセスが可能な為、「サブスクライブ済みコンテンツライブラリ」を選択し、サブスクリプションURLに以下を入力します。

「https://wp-content.vmware.com/v2/latest/lib.json」URLは変更される可能性がある為、適宜ドキュメントを参照下さい。

Tanzu Kubernetes クラスタのサブスクライブ済みコンテンツ ライブラリの作成

「はい」をクリックします。

「ストレージポリシー」をクリックし、「NEXT」をクリックします。

コンテンツライブラリが作成されます。「FINISH」をクリックします。

続々とOVFがダウンロードされ始めました。TKG用のVMでしょうか。

「名前空間」-「サマリ」ー「Tanzu Kubernetes」から「ライブラリの追加」をクリックします。

「ライブラリの追加」をクリックします。

コンテンツライブラリを選択し、「OK」をクリックします。

コンテンツライブラリとの同期が完了するとTanzu kubernetesクラスタが0として表示されました。Tanzu kubernetesクラスタを払い出す準備ができたものと思われます。

次回はNative Podを作成してみてコンテナへのアクセスまでを実施します。

VMware Tanzu デプロイしてみた① ワークロード管理の有効化から名前空間の作成

今回からはVMware Tanzuをキャッチアップしてみようと思います。

VMware Tanzuを構成する為にはNSX-T環境が必須となる為、事前にNestedのらぼ環境を構成済みです。ではさっそく始めます。

NSX-T 3.0 Tier0、Tier1ゲートウェイの作成、テナントネットワークの作成

「メニュー」ー「ワークロード管理」をクリックします。

NSX-T構成済みのvSphere環境で以下の条件を満たしている場合は「有効化」をクリックします。

クラスタがセットアップされている事。

DRS及びHAが有効化されている事。

vsphere7 with kubernetesライセンスが適用されている事。

適用する「クラスタ名」にチェックを入れ「次へ」をクリックします。

制御プレーンVMのサイズを選択し、「次へ」をクリックします。

3台払い出されます。

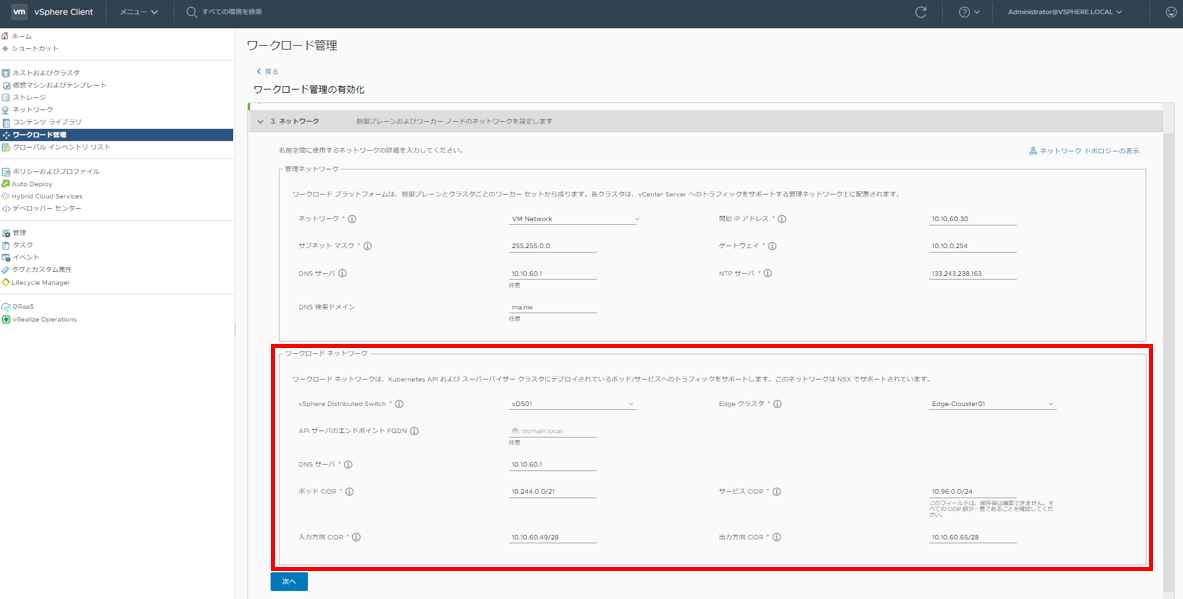

管理ネットワークの情報を記入します。

特に注意する点はないですが、「開始IPアドレス」から3台分のIPアドレスが払い出されます。

ワークロードネットワークの情報を以下を参考に入力し「次へ」をクリックします。

「vSphere Distributed Switch」:NSXT環境で利用しているvDSを選択する

「Edgeクラスタ」:NSXT環境で作成済みのEdgeクラスタ名を選択する

「ポッドCIDR」デフォルト(10.244.0.0/21)から変更不要。NSX-T LB用のセグメント作成に利用されます

「サービスCIDR」デフォルト(10.96.0.0./24)から変更不要。NSX-T LBの分散ロードバランサIPアドレスとして使用されます

「入力方向CIDR」任意で入力。NSX-Tロードバランサのアドレスと使用されTanzu環境へアクセスする際のURLとなります

「出力方向CIDR」任意で入力。入力方向CIDRと通信できるセグメントを入力する

利用するストレージを選択し「次へ」をクリックします。

※事前にデータストアをタグ付けし、ストレージポリシーと紐づける必要があります。

「完了」をクリックするとデプロイが開始されます。

30分程度かかる為様子を見ていましたが、制御プレーンVMの払い出しや、Tier-1GWの構成、ロードバランサの構成などが自動で行われます。

完成しました。

NSX-T側の設定を事前にしっかり行えていればデプロイ自体は非常にシンプルに行えるソリューションの様です。

最初に名前空間を作成します。筆者は名前空間って何??ってレベルです。

「名前」を任意で入力し「作成」をクリックします。

正常に名前空間が作成された様です。くどい様ですが筆者は名前空間って何?ってレベルです。

ステータスから「開く」をクリックしてみます。

LBのURLが表示されKubernetes用のCLI Toolsなどがダウンロード可能な様です。

ストレージと権限の追加を触ってみます。

ほぼ選ぶだけです。

権限とストレージの割り当てが可能になりました。

次回はTanzu kubenetesを利用する為に必要なコンテンツライブラリの作成を予定しています。

VMware Tanzu デプロイしてみた② コンテンツライブラリの作成

NSX-T 3.0 Tier0、Tier1ゲートウェイの作成、テナントネットワークの作成まで。

前回までの記事は以下から

前回に引き続きテナントネットワークの作成を目標にTier0、Tier1ゲートウェイの作成を行います。グレーアウト部分に関しては前回記事にてご紹介済みです。

まずはTier0GWの作成から行います。

「ネットワーク」ー「Tier-0ゲートウェイ」-「ゲートウェイの追加」をクリックします。

以下を入力し、「保存」をクリックします。

「Tieer-0ゲートウェイの名前」:任意で入力します

「HAモード」アクティブ/スタンバイ ※らぼ環境にてEdgeVMシングル構成の為

「Edgeクラスタ」前回記事にて作成したEdgeクラスタを選択します。

Tier-0GWに追加の設定を行うかのポップアップが表示される為、「はい」をクリックします。※誤っていいえをクリックした場合は、「編集」をクリックしてください。

「インタフェース」プルダウンを表示させ、「設定」をクリックします。

「インターフェースの追加」をクリックします。

以下を入力し、「保存」をクリックします。

「名前」:任意で入力します。

「IPアドレス/マスク」:Tier0のアップリンクインタフェースとなるIPアドレス/サブネットで入力を行います。

「接続先」:前回記事で事前準備としてに払い出したセグメントを選択します。

「Edgeノード」:前回記事で作成したEdgeVMを選択します。

IPアドレスが設定された事を確認し「閉じる」をクリックします。

※状態はすぐに成功ステータスとなります。

次に「ルーティング」プルダウンを表示させスタティックルートの「設定」をクリックします。

「スタティックルートの追加」をクリックし、以下を入力後、「ネクストホップの設定」を行います。

「名前」:任意で入力

「ネットワーク」:任意のネットワーク。※今回はすべてを対象としたい為、0.0.0.0/0を入力しています。

「IPアドレス」にゲートウェイを追加し、「追加」をクリックします。

スタティックルートが追加されたことを確認して、「閉じる」をクリックします。※状態はすぐに成功ステータスに代わります。

「設定を終了」をクリックします。

Tier-0ゲートウェイが追加されました。

ここまででVMware Tanzu環境の構築準備が整った為、次回以降でご紹介したいと思います。

今回の記事では引き続きTier-1ゲートウェイの設定、テナントセグメントの払い出しまでを紹介します。

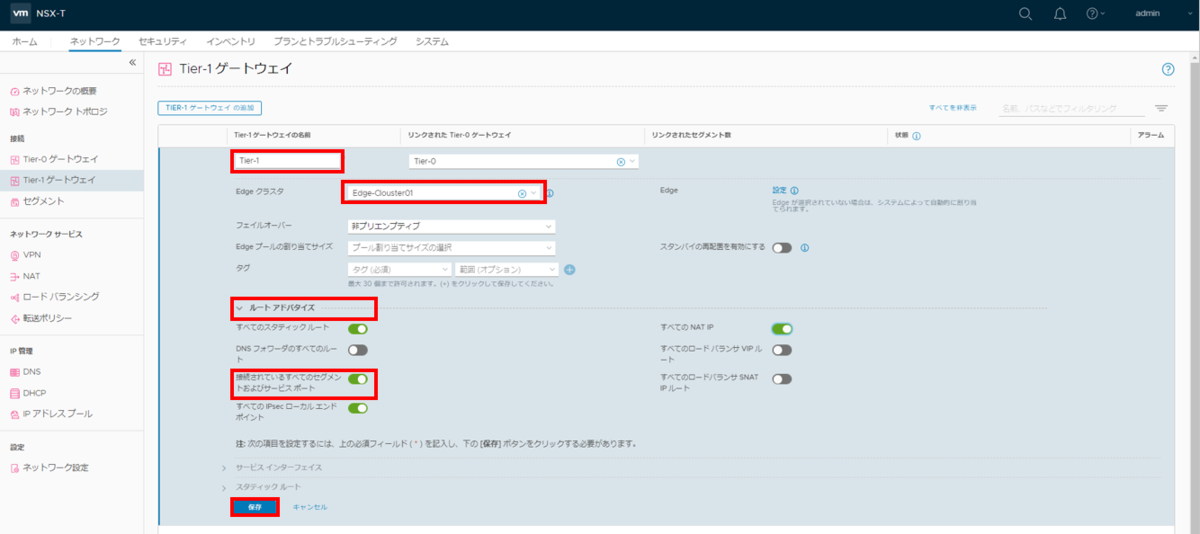

続いてTier-1ゲートウェイの作成に移ります。

「Tier-1ゲートウェイ」ー「Tier-1ゲートウェイの作成」をクリックします。

以下を入力し、「保存」をクリックします。

「名前」:任意で入力します。

「Edgeクラスタ」:前回記事で作成したEdgeクラスタを選択します。

「ルートアドバタイズ」必要な物にチェックを入れます。今回は「構成されているすべてのセグメイト及びサービスサポート」を有効化します。

Tier-1ゲートウェイが構成されました。

最後にテナントセグメントの払い出しを行います。

「セグメント」ー「セグメント」ー「セグメントの追加」をクリックします。

以下を入力し、「保存」をクリックします。

「セグメント名」:任意で入力します。

「接続」:先ほど作成したTier-1ゲートウェイを指定します。

「トランスポートゾーン」前々回記事で作成したオーバレイネットワーク用のトランスポートゾーンを指定します。

「サブネット」テナントネットワークのGWアドレスおよびサブネットを指定します。

セグメントが正常に払い出されました。「いいえ」をクリックします。

NSX-Tのトポロジ上は上記の様な構成になってます。

仮想マシンへのネットワーク接続は省略しますが、疎通できるか確認を行います。

オーバーレイネットワークを利用しているVMからTier1GWアドレスやTier0GWのアップリンク用インタフェースアドレスへの疎通が可能な事が確認できました。

らぼ環境でもしっかりと稼働していそうです。

次回は以下を予定しています。

VMware Tanzuデプロイしてみた。

NSX-T 3.0 Edgeトランスポートノードの作成

前回までの記事は以下から

前回はNested環境を利用したNSX-T 3.0環境のラボ構築までをご紹介しました。

今回から数回でSNX-T環境を用いたテナントネットワークの作成方法をご紹介します。

上記の様なテナントネットワークを作成する目標で今回の記事では以下の部分を作成します。※目標のネットワーク10.10.0.254/16はVSSからじゃないとアクセスできない環境要因の為少し複雑なEdgeの構成で作成します。

今回はEdge トランスポートノードの作成が範囲の為グレーアウトしている部分の設定は次回以降にご紹介します。それではさっそく作成しましょう。

まずは事前準備としてTier0ゲートウェイのアップリンクとして利用するセグメントを払い出します。アップリンクネットワークとして利用する為、オーバレイネットワークは利用せず、VLANネットワークとして払い出します。

「ネットワーク」ー「セグメント」ー「セグメント」ー「セグメントの追加」をクリックします。

以下を入力し「保存」をクリックします。

「セグメント名」:任意で入力します。

「トランスポートゾーン」前回の記事で作成したVLAN用のトランスポートゾーンを指定します。

「VLAN」任意のVLANを指定します。今回はタグ無しで実施しています。

VLANセグメントが払い出されました。

「システム」ー「ファブリック」ー「ノード」ー「Edgeトランスポートノード」ー「Edge仮想マシンの追加」をクリックします。

「名前」「ホスト名」を任意で入力し、「EdgeVMのサイズを選択」後、「次へ」をクリックします。

LBを払い出す必要があるVMware Tanzuの動作確認を今後行いたい為、今回はLargeを選択します。

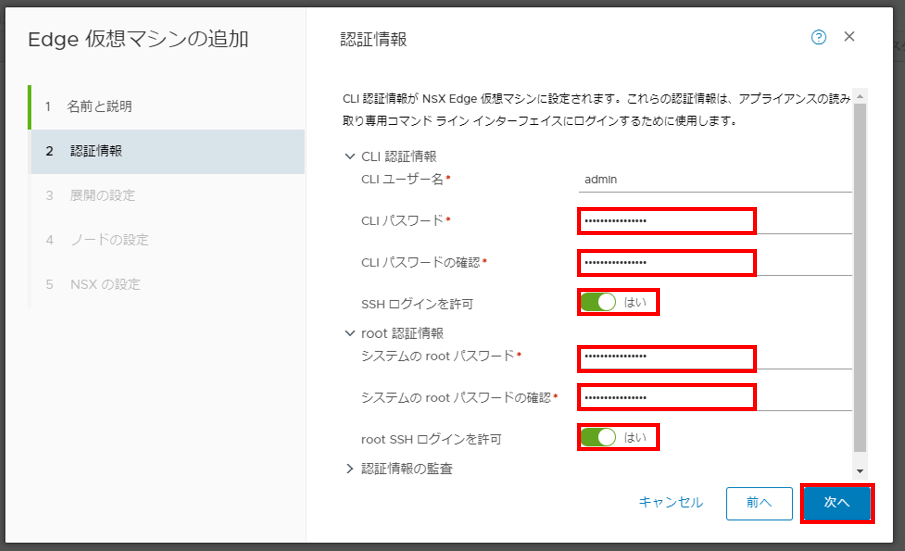

パスワードを入力し「次へ」をクリックします。SSHログインに関してはデフォルトで無効になっている為、必要に応じてチェックを入れてください。

EdgeVMの管理用ネットワークの設定を行い、「次へ」をクリックします。

「管理IP」:割り当てるIPアドレス/サブネット形式で入力します。

「デフォルトゲートウェイ」:GWを入力

「ドメイン名の検索」:任意で入力

「DNSサーバ」:任意で入力

「NTPサーバ」:任意で入力

次にTier0,Tier1ゲートウェイで利用するインタフェースの設定を行います。

まずはオーバレイネットワークを利用する為のインタフェースの設定を行います。

以下項目を設定し、「スイッチの追加」をクリックします。

「Edgeスイッチ名」:任意で入力

「トランスポートゾーン」:前回記事で作成したオーバレイ用のトランスポートゾーンをプルダウンから選択します。

「アップリンクプロファイル」:前回記事で作成したアップリンクプロファイルを利用します。

「IPの割り当て」:IPプールを使用を選択します。固定IPにして任意で入力する事も可能です。

「IPプール」:前回記事で作成したIPプールを設定します。Edge用のTEPIPとして払い出されます。

「EPDK Fastpathインターフェイス」利用するポートグループを選択します。オーバレイネットワーク用の為VDS上のポートグループである必要があります。ポートグループはvSphereからトランクポートとして別途作成してください。

次にアップリンク用のインタフェースの設定を行います。

以下項目を設定し、「終了」をクリックします。

「Edgeスイッチ名」:任意で入力

「トランスポートゾーン」:前回記事で作成したVLAN用のトランスポートゾーンをプルダウンから選択します。

「アップリンクプロファイル」:前回記事で作成したアップリンクプロファイルを利用します。

「EPDK Fastpathインターフェイス」利用するポートグループを選択します。VLAN通信の為VSS上のポートグループを選択する事も可能です。ポートグループはvSphereからトランクポートとして別途作成してください。

EdgeVMが作成され稼働中のステータスになりました。

先ほど作成したEdgeVMをEdgeクラスタとして設定します。

らぼ環境なので1台しかデプロイしませんが、設定としては必須です。

「Edgeクラスタ」ー「追加」をクリックします。

「名前」を任意に入力し、先ほど作成したEdgeVMにチェックを入れ→で選択済み枠に移動させた後、「追加」をクリックします。

Edgeクラスタが作成されました。※メンバーは1台です。

次回はTier0、Tier1ゲートウェイを作成し、テナントネットワーク通信まで設定します。

NSX-T 3.0 Tier0、Tier1ゲートウェイの作成

NSX-T 3.0 ラボ環境の作成。

NSX-T Data Center 3.0がリリースされて暫く経ちますが、vSphere7に導入するのが以前より容易になったとの噂を聞きつけラボ環境を作成してみる事にしました。NSX-Vとの差異や新機能をキャッチアップしたいと思います。

らぼは以下の通りの構成で作成してみます。

あくまでらぼ環境なのでNSXManagerはシングル構成で実施します。

アプライアンスデプロイ

アプライアンスデプロイに関しては改めてご紹介する必要はないと思うので省きますが適宜パラメータを入力してください。注意点は設定しなくてよいパラメータの入力欄がある事です。

NSX-T環境の構築

ログイン

まずはログインを行います。

ユーザ名とパスワードはアプライアンスデプロイ時に指定した値です。

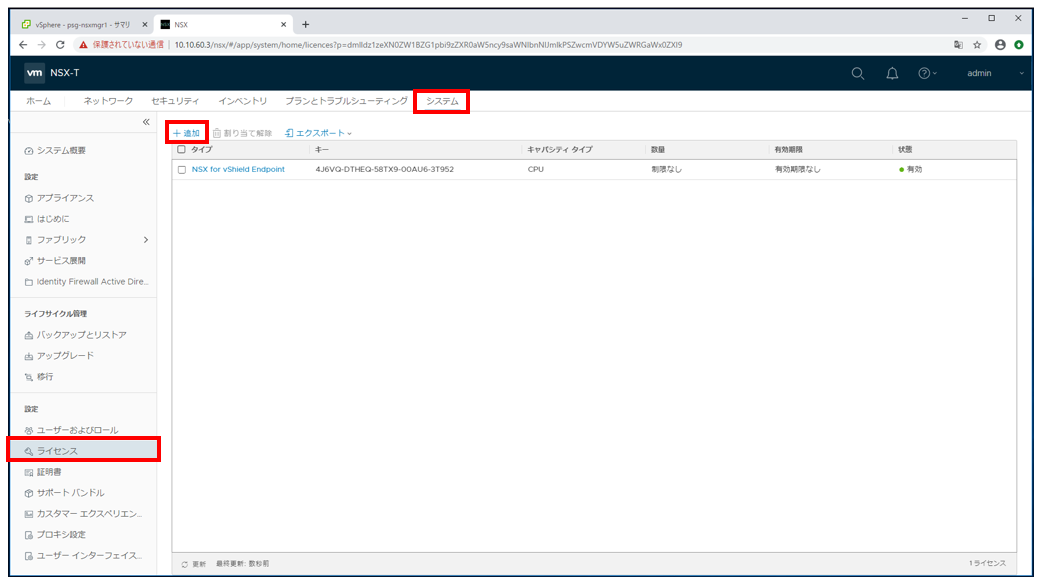

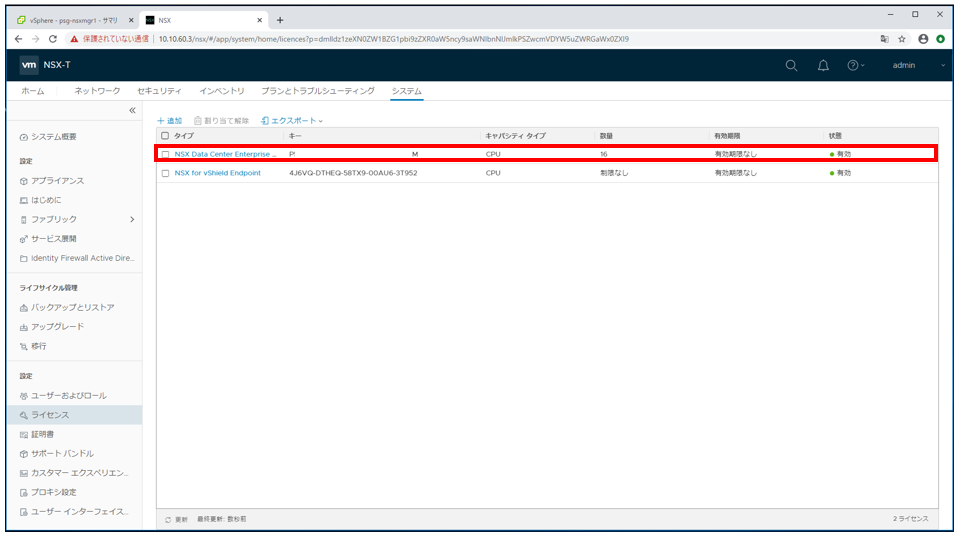

ライセンス

まずはライセンスを適用します。

「システム」ー「ライセンス」ー「追加」をクリックします。

ライセンスキーを投入し、「追加」をクリックします。

ライセンスが適用されました。

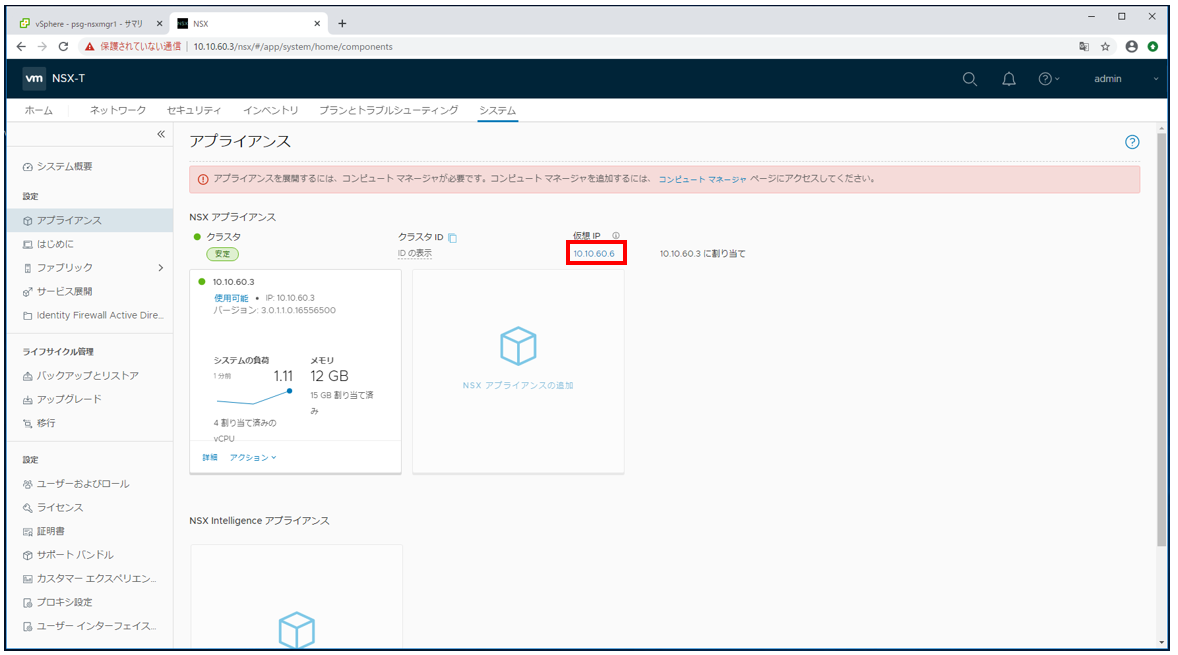

仮想IPの設定

今回はNSXManagerを単独構成で構築する為必要はありませんが仮想IPを設定可能です。もちろん単独構成であっても仮想IPでの管理UIアクセスは可能です。

「システム」ー「アプライアンス」ー「仮想IPの設定」をクリックします。

「仮想IPアドレス」を入力し、「保存」をクリックします。

仮想IPが設定されました。

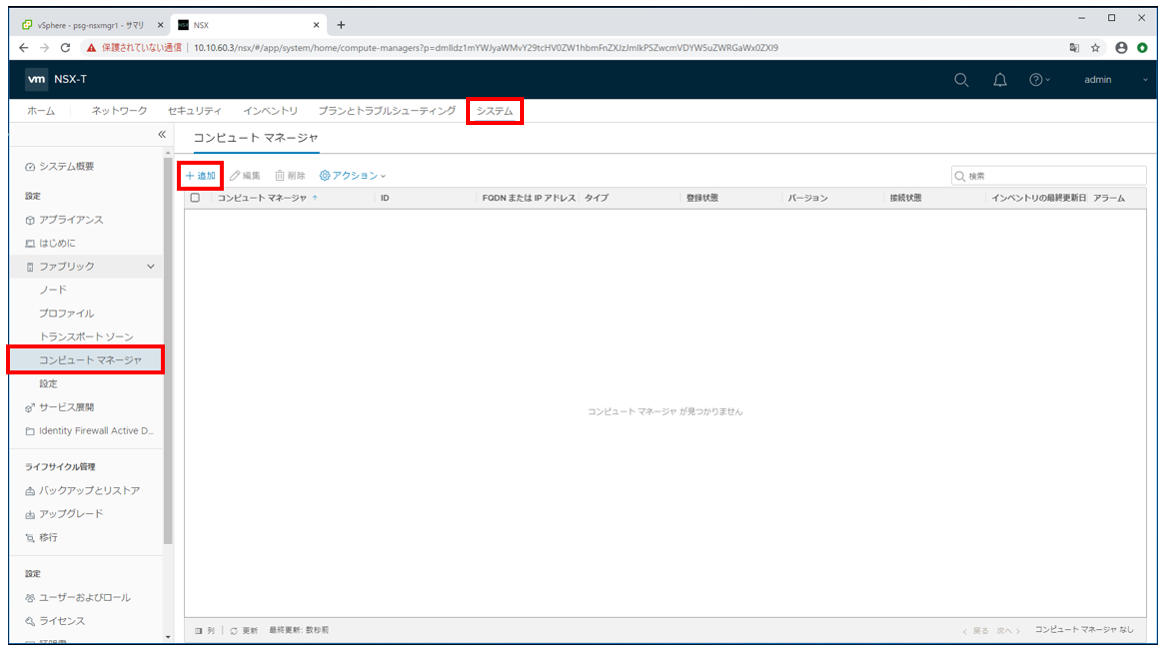

コンピュートマネージャ

ラボ環境のvCenterをコンピュートマネージャオブジェクトとして登録します。

オーバレイネットワークの払い出し先やTEP用kernelの作成などはすべて登録されたvCenter上で行われます。

※NSXmanagerを追加する場合は登録したコンピュートマネージャ上に展開される為、複数払い出す場合は注意してください。1台目を物理側にデプロイした場合、2.3台目をNested側に展開する事になります。通信が可能であれば動作自体は問題ありません。

物理側のvCenterをコンピュートマネージャ上に登録する事も可能ですが、物理側でもNSX-T環境化である場合はvCenterの取り合いになります。

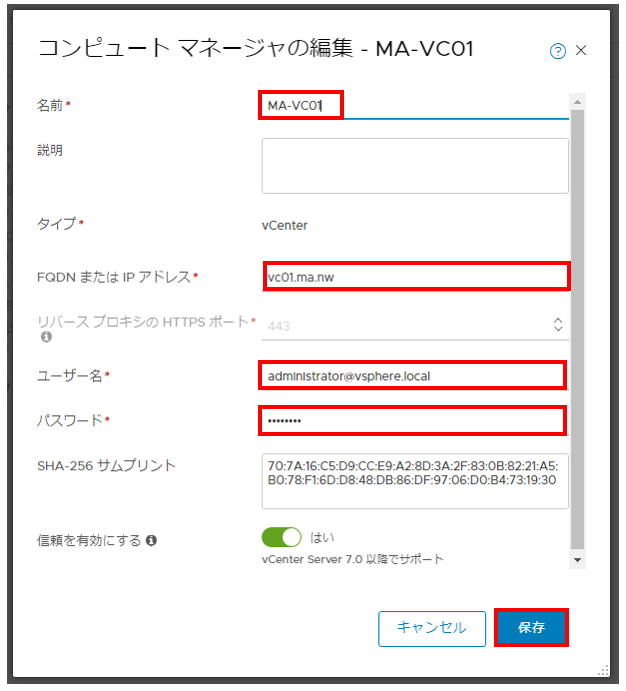

「システム」ー「コンピュートマネージャ」ー「追加」をクリックします。

「名前、FQDN(IP可)、ユーザパスワード」を入力し「保存」をクリックします。

「追加」をクリックします。

コンピュートマネージャオブジェクトとしてらぼ環境のvCneterが登録されました。

トランスポートゾーン

トランスポート ゾーンでは、特定のネットワークを使用できるホストと仮想マシンを指定する為のプロファイルを作成します。

シンプルな環境なのでオーバレイ用、VLAN用に各1つ作成します。

「システム」ー「トランスポートゾーン」ー「トランスポートゾーン」ー「追加」をクリックします。

「名前とスイッチ名」を入力し、トラフィックタイプに「オーバーレイ」を選択し「追加」をクリックします。スイッチ名に関しては任意で構いません。

同様の手順でトラフィックタイプを「VLAN」に設定し、2つ目のトランスポートゾーンを作成します。2つのトランスポートゾーンが作成されました。

アップリンクプロファイル

NSX Edge ノードから物理スイッチへの紐づけを行うプロファイルです。

チーミングポリシーやオーバレイネットワークが利用するVLANID等を指定します。

「システム」ー「プロファイル」ー「アップリンクプロファイル」ー「追加」をクリックします。

「名前とVLANID」を入力し、「保存」をクリックします。

※MTUに関しては入力しないでください。Nested側のVDSに設定されているMTUが採用されます。アップリンクプロファイルに入力するとNSX-T環境が動作しません。

IPアドレスプール

L3サブネットを定義します。様々な場面で利用されますが

今回はTEP-karnel払い出し用のアドレスプールを作成します。

「ネットワーク」ー「IPアドレスプール」ー「IPアドレスプール」ー「IPアドレスプールの追加」をクリックします。

「名前」を入力し、サブネットの「設定」をクリックします。

以下を入力し、「追加」をクリックします。

IP範囲「TEP-karnelに利用するIPアドレスの範囲」必須

CIDR「ネットワークアドレス/**」必須

ゲートウェイIP「任意」

DNS「任意」

サフィックス「任意」

「適用」をクリックします。

「保存」をクリックします。

IPアドレスプールが作成されました。

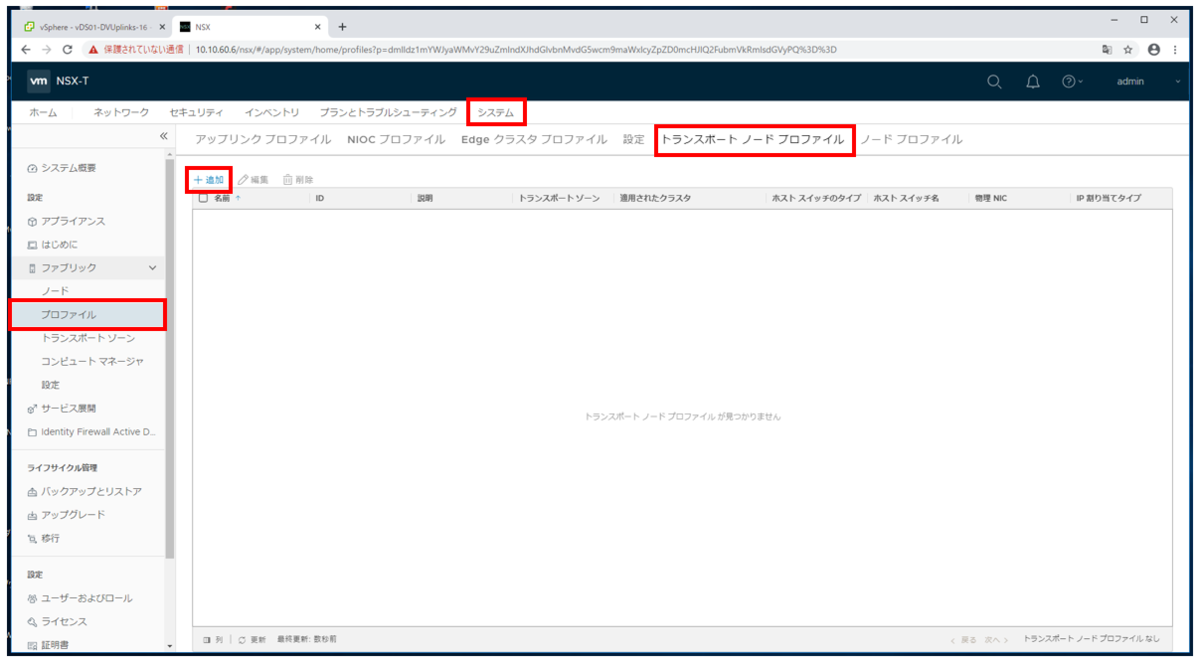

トランスポートノードプロファイル

クラスタに適用される構成を定義するプロファイルです。

トランスポート ゾーン、N-VDS スイッチの設定(アップリンク プロファイル、IP アドレスの割り当て(TEP)、物理 NIC とアップリンク仮想インターフェイスのマッピングなど)を定義します。

「システム」ー「プロファイル」ー「トランスポートノードプロファイル」ー「追加」をクリックします。

以下の項目を入力し、「追加」をクリックします。

名前「任意」

タイプ「VDs」※vSphere7.0以降

モード「標準」

名前「コンピュートマネージャ名を選択」「vCenter配下のVDSを選択」

トランスポートゾーン「作成したトランスポートゾーンを指定」

アップリンクプロファイル「作成したアップリンクプロファイルを指定」

IPの割り当て「IPプールを使用」

IPプール「作成したIPアドレスプールを指定」

VDSアップリンク「Nested側VDSのアップリンクを指定」

トランスポートノードプロファイルが作成されました。

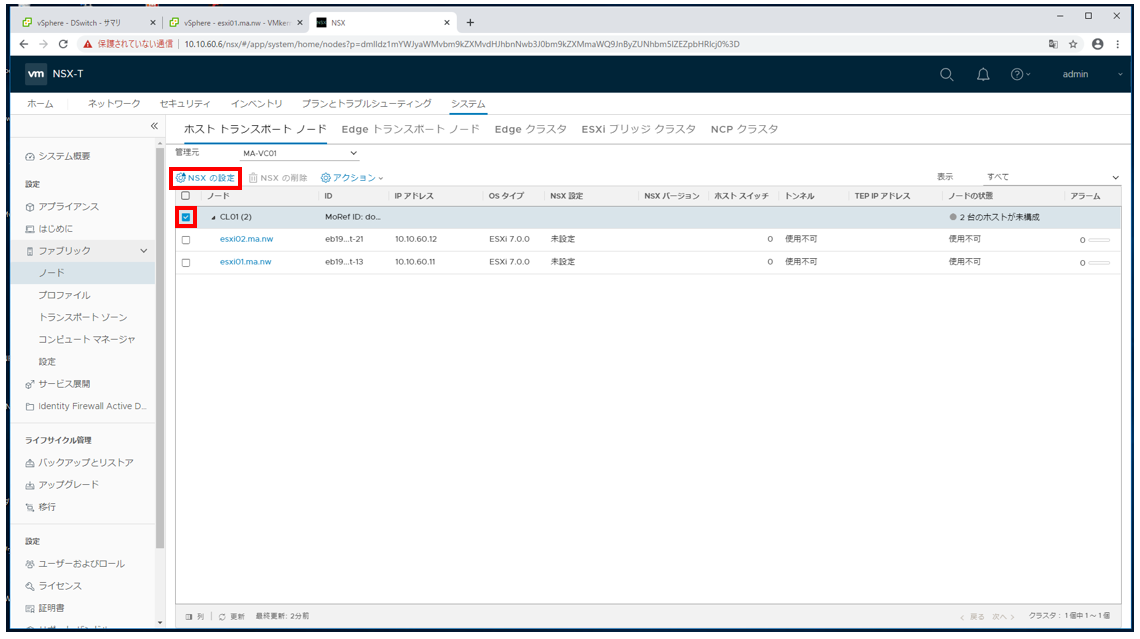

トランスポートノード

トランスポート ノードは、NSX-T オーバーレイ、 NSX-T VLAN ネットワークに参加するノードです。事前設定が済んでいればあとは追加するだけです。

「システム」ー「ノード」ー「ホストトランスポートノード」ー「管理元でコンピュートマネージャオブジェクトを選択」

「導入対象のクラスタ」にチェックを入れ、「NSXの設定」をクリックします。

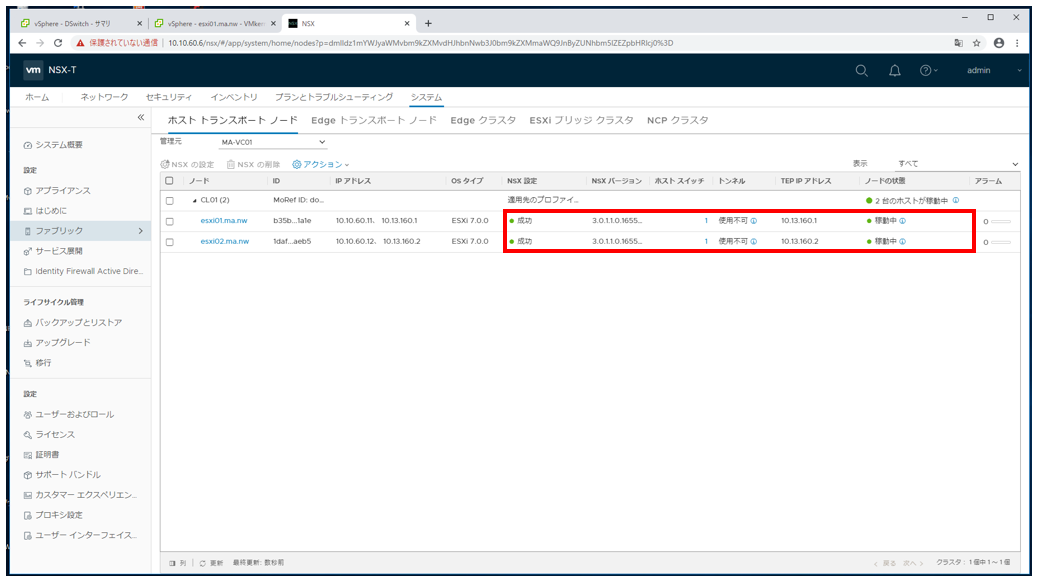

「作成したトランスポートノードプロファイル」を選択し、「適用」をクリックします。

ホストへのインストールが開始されます。

ホストへのNSXインストールが完了しました。

TEP用のカーネルがvSphere側に作成されました。

稼働確認

オーバレイセグメントを一つ作成し、仮想マシン間の疎通確認を実施してみます。

「ネットワーク」ー「セグメント」ー「セグメント」ー「セグメントの追加」をクリックします。

以下を入力し、「保存」をクリックします。

セグメント名「任意」

トランスポートゾーン「オーバレイ用に作成したトランスポートゾーン」

セグメントが追加されました。

vCenter上にオーバレイネットワークを利用したポートグループが作成されました。

テストVM間での疎通が可能である事まで確認できました。

問題なく利用できそうです。

パスワードの有効期間が短い為上記を忘れないでください。

次回からはテナントネットワークの作成を目標にEdgeトランスポートノードの払い出しを紹介します。

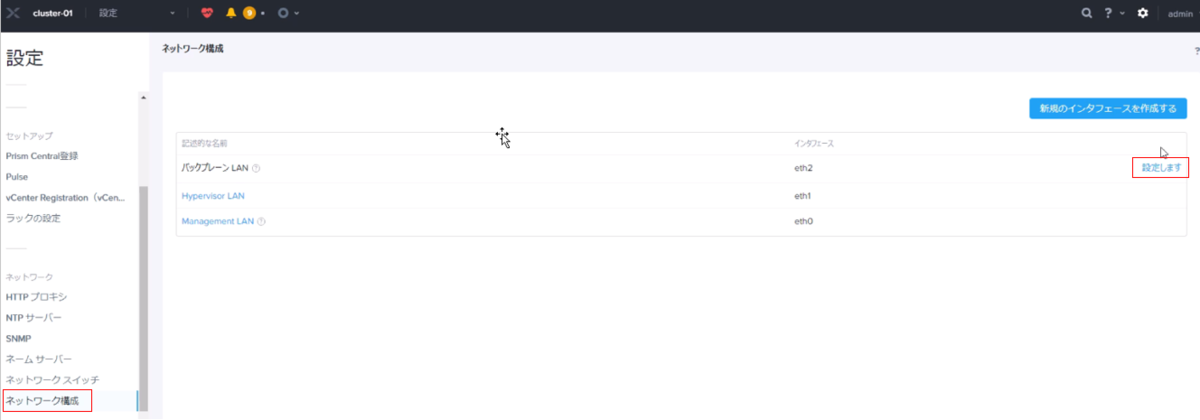

【Nutanix】 バックプレーンネットワークのセグメントを分割してみる。

Foundationを利用してNutanixクラスタを構築する際、バックプレーンネットワークのセグメント化は行えず、初期構築時はCVMの管理セグメントを通じてバックプレーンネットワークの通信が行われます。

バックプレーンネットワークのセグメント化を行う場合は以下のマニュアルを元に実施する事になります。

早速やってみます。

まずは物理スイッチとvSphereでの事前準備を行います。

物理スイッチ側へのTAGVLANの追加とvSphere上でポートグループの追加を行います。

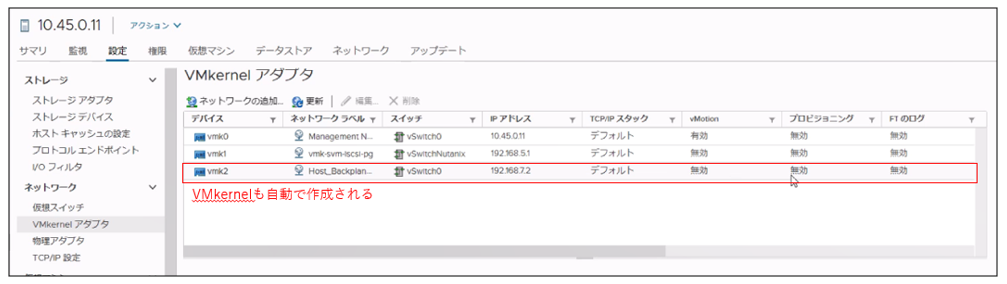

事前にVMkernelを作成する必要はありません。Prismからセグメント化を実施する際に自動で追加されます。

Prism上で「ネットワーク構成」-「設定します」をクリックします。

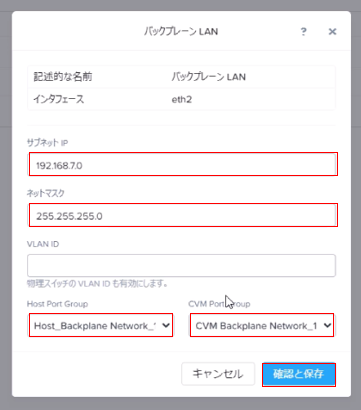

「サブネット」「ネットマスク」を入力し、事前準備で作成したポートグループを指定します。Host Port Groupを利用してVMkernelが作成されCVM Port Groupとして指定したPort GroupをCVMのバックプレーンネットワークが差し変わります。

タスクが開始されます。

まず最初にCVMのポートが指定したPort Groupに差し変わります。

この時点でデータの信頼性の状態がCritical表示になります。

続いてVMkernel Portが自動で作成されます。

最後にCVMが分割されたセグメントのIPを保持します。

タスクが完了し、データの信頼性がグリーン表示となります。

作成されたVMkernelを通じてバックプレーンネットワークの通信が行われている事を確認できます。

vCloud Director 10.0 番外編② 外部で作成されたワイルドカード証明書の適用

-------------------------------------過去記事は以下から-------------------------------------

vCloud Director 10.0 ①インストール (プライマリ)

vCloud Director 10.0 ②インストール (スタンバイ)と公開アドレス

vCloud Director 10.0 ③ vCloud Director へのvSphereリソースの登録

vCloud Director 10.0 ④ 組織及び組織vDCの作成

vCloud Director 10.0 ⑤ テナントへのNSXEdgeの導入とサービスの構成

vCloud Director 10.0 ⑥ 組織vCDネットワークの作成

vCloud Director 10.0 ⑦ vCloud Director上での新規仮想マシンの作成

vCloud Director 10.0 番外編① vCloud Director Applianceのアップグレード

-------------------------------------------------------------------------------------------------

今回はvCloud Director Applianceの証明書適用に関しての記事を投稿します。

vCloud Director Appliance環境ではデプロイ時に自己証明書が作成されデフォルトで使用されます。アクセスすると以下の様自己証明書が使用されている為、コンソールが表示されません。

VMware社のドキュメントでは以下フローで、証明書差し替え手順として公開されています。

・JAVA keytoolを使用して、自己証明書を作成する

・証明書署名リクエストを作成する

・証明書署名要求を認証局に送信する

・認証局のルート証明書をインポートする

・署名済み証明書をインポートする

これまでに関わった本番環境の導入時はCell ServerでCSRを生成して送信することができず、代わりに作成済みのプライベートキーとワイルドカード証明書、ルート証明書が提供されるケースがあります。

この様なケースはCell Serverがアプライアンスで提供される様になり、高可用性構成での導入が容易になった事でより多く見かけるようになりました。

今回はプライベートキーとワイルドカード証明書、ルート証明書をPFXファイルに変換し、Cell Serverにインポートする方法を公開します。

①Cell Serverにログインしプライベートキー、ワイルドカード証明書、ルート証明書を配置します。今回は以下のファイルで進めます。

プライベートキー:private.key

サーバ証明書:server.cer

ルート証明書:root.cer

②opensslを利用しPFXファイルを作成します。パスワードが求められれば、プライベートキーのパスフレーズを入力します。

openssl pkcs12 -export -inkey private.key -in server.cer -certfile root.cer -out server.pfx

Enter Export Password:パスフレーズを入力

Verifying - Enter Export Password:パスフレーズを入力

③デフォルトのキーストアファイルをコピーします。

cp /opt/vmware/vcloud-director/certificates.ks /opt/vmware/vcloud-director/certificates-new.ks

④コピーしたキーストアファイルにPFXファイルをインポートします。※エイリアスは1

/opt/vmware/vcloud-director/jre/bin/keytool -trustcacerts -storetype JCEKS -storepass VMware1! -importkeystore -srckeystore server.pfx -destkeystore /opt/vmware/vcloud-director/certificates-new.ks -srcstoretype pkcs12

⑤同じコマンドでキーストアファイルにPFXファイルをインポートします。※エイリアス1が使用されている為、上書きをせずに2としてインポートします。

/opt/vmware/vcloud-director/jre/bin/keytool -trustcacerts -storetype JCEKS -storepass VMware1! -importkeystore -srckeystore server.pfx -destkeystore /opt/vmware/vcloud-director/certificates-new.ks -srcstoretype pkcs12

Existing entry alias 1 exists, overwrite? [no]: no

Enter new alias name (RETURN to cancel import for this entry): 2

⑥キーストアの証明書リストを表示します。

デフォルトのエイリアス(http,consoleproxy)に加えて項番⑤で追加したエイリアス(1,2)が追加されています。

/opt/vmware/vcloud-director/jre/bin/keytool -storetype JCEKS -storepass VMware1! -keystore /opt/vmware/vcloud-director/certificates-new.ks -list

⑦デフォルトエイリアス(http)を削除します。

/opt/vmware/vcloud-director/jre/bin/keytool -delete -alias http -keystore /opt/vmware/vcloud-director/certificates-new.ks -storetype JCEKS -storepass VMware1!

⑧デフォルトエイリアス(onsoleproxy)を削除します。

/opt/vmware/vcloud-director/jre/bin/keytool -delete -alias consoleproxy -keystore /opt/vmware/vcloud-director/certificates-new.ks -storetype JCEKS -storepass VMware1!

⑨リストを表示させます。エイリアスが(1,2)のみである事を確認します。

/opt/vmware/vcloud-director/jre/bin/keytool -storetype JCEKS -storepass VMware1! -keystore /opt/vmware/vcloud-director/certificates-new.ks -list

⑩エイリアス1の名前をhttpに変更します。

/opt/vmware/vcloud-director/jre/bin/keytool -storetype JCEKS -storepass VMware1! -changealias -alias 1 -destalias http -keystore /opt/vmware/vcloud-director/certificates-new.ks

⑩エイリアス2の名前をconsoleproxyに変更します。

/opt/vmware/vcloud-director/jre/bin/keytool -storetype JCEKS -storepass VMware1! -changealias -alias 2 -destalias consoleproxy -keystore /opt/vmware/vcloud-director/certificates-new.ks

⑪エイリアスを表示させます。PFXファイルからインポートしたエイリアス(1,2)の名前がエイリアス(http,consoleproxy)変更されている事を確認します。

/opt/vmware/vcloud-director/jre/bin/keytool -storetype JCEKS -storepass VMware1! -keystore /opt/vmware/vcloud-director/certificates-new.ks -list

⑫項番③でコピーしたキーストアを移動します。

mv /opt/vmware/vcloud-director/certificates-new.ks /opt/vmware/vcloud-director/certificates.ks

⑬キーストアファイルの所有権を更新します。

chown vcloud:vcloud /opt/vmware/vcloud-director/certificates.ks

⑭vCDサービスを停止します。

service vmware-vcd stop

⑮更新したキーストアを使用するようにvCloud Directorを再構成します。サービスを開始するかどうか尋ねられたら、「Y」と答えます。

/opt/vmware/vcloud-director/bin/configure

Start it now? [y/n]y

⑯証明書が更新され、コンソールが表示されました。

今回はここまで。