vRealize Automation 8 やってみた⑦ ブループリント(Cloud Template)

前回まではこちら

vRealize Automation 8 やってみた ① 導入編

vRealize Automation 8 やってみた ② クイックスタート編

vRealize Automation 8 やってみた③ クラウドアカウントの登録

vRealize Automation 8 やってみた④ Cloud Zones or Virtual Private Zones

vRealize Automation 8 やってみた⑤ タグの設定

vRealize Automation 8 やってみた⑥ プロジェクト

6回目まででおおよその下準備が整ったので今回はCloud Templateの作成を行います。

デフォルトのテンプレートだと細かい指定は行えない為少し手をいれて、ユーザがデプロイリクエストを行う際にCPU、メモリの指定、ネットワークの指定、追加ディスクの指定etcを行えるような形のテンプレートを作成します。

①[Design]-[Cloud Template]-[NEW FROM]-[Blank canvas]をクリックします。

②[name][project]を入力及び選択し、[CREATE]をクリックします。

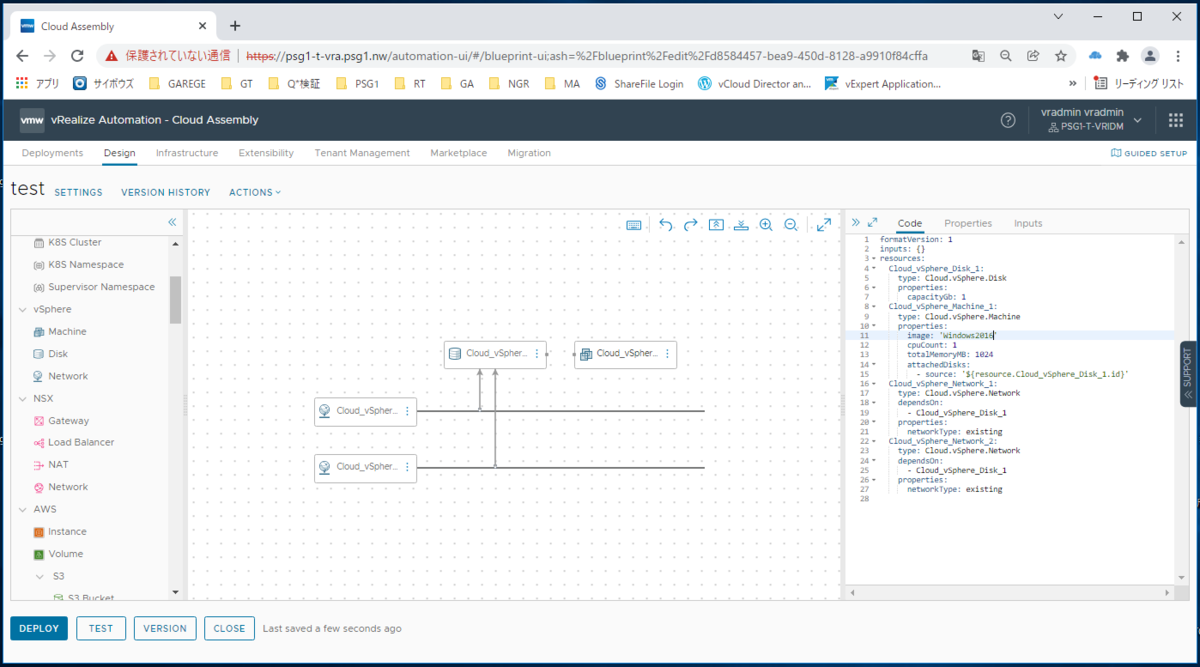

③vSphere-[Machine1つ、Network2つ、Disk1つ]をドロップします。

④オブジェクトを繋げます

⑤オブジェクトを繋げCodeのimageをクリックし、利用可能なイメージを選択します。

⑤オブジェクトを繋げCodeのimageをクリックし、利用可能なイメージを選択します。

⑤表示上は右のyamlにエラーは見られななりましたが、現段階でデプロイ時に全くカスタマイズが行えない状態のyamlになってます。

インプット項目にに色々と入力し各々指定可能にしてあげます。

⑥インプットの項目が非常に長くなりました。

事項でどのような設定が施されているのか説明します。

⑦インプットに事前に定義しておきリソースはインプットの指定に従うような形のCloud templateが完成しました。下記は一例です。CPUやmemoryのデフォルト、カウント等はそのまま利用できますがNetwork等に関してはTagsから引っ張ってくる為事前の設定が必要です。

vRealize Automation 8 やってみた⑤ タグの設定

formatVersion: 1

inputs:

vmname:

type: string

title: VM name

image:

type: string

enum:

- Windows2016

- Windows2019

- Windows2016_thin

- Cent8

title: Select a image

cpucount:

type: number

default: 2

title: CPU Count

cpupersocket:

type: number

default: 2

title: CPU core per sokcet

memory:

type: number

default: 4096

title: Memory Size (MB)

boot_disk:

type: number

default: 50

title: Boot Disk Size (GB)

attach_disk:

type: number

default: 100

title: Attach Disk Size (GB)

network1:

type: string

enum:

- VLAN-165

- VMnetwork2

- VLAN-170

title: network1

network2:

type: string

enum:

- VLAN-165

- VMnetwork2

- VLAN-170

title: network2

resources:

Cloud_vSphere_Machine_1:

type: Cloud.vSphere.Machine

properties:

name: '${input.vmname}'

image: '${input.image}'

cpuCount: '${input.cpucount}'

coreCount: '${input.cpupersocket}'

totalMemoryMB: '${input.memory}'

networks:

- network: '${resource.Cloud_vSphere_Network_1.id}'

- network: '${resource.Cloud_vSphere_Network_2.id}'

attachedDisks:

- source: '${resource.Cloud_vSphere_Disk_1.id}'

storage:

bootDiskCapacityInGB: '${input.boot_disk}'

Cloud_vSphere_Disk_1:

type: Cloud.vSphere.Disk

properties:

capacityGb: '${input.attach_disk}'

provisioningType: thin

dataStore: Nutanix

Cloud_vSphere_Network_1:

type: Cloud.vSphere.Network

properties:

constraints:

- tag: 'Network:${input.network1}'

Cloud_vSphere_Network_2:

type: Cloud.vSphere.Network

properties:

constraints:

- tag: 'Network:${input.network2}'

⑧TESTをクリックします。

⑨様々なリソースを設定可能なCloud templateとなっている事がテスト時の項目からわかります。もろもろ入力し、TESTをクリックします。

⑩テスト結果がSuccessfulで表示され正常に使えそうなことが分かります。

⑪バージョンをクリックします。

⑫virsionに番号を入力し、Releaseにチェックを入れ、CREATEをクリックします。

※Releaseに☑を入れないと利用可能にはなりません。

⑬Closeをクリックします。

以上でCloud Templateの作成は終了です。次回からはセルフサービスポータルへの公開方法や承認の設定方法等を紹介します。

vRealize Automation 8 やってみた⑥ プロジェクト

前回まではこちら

vRealize Automation 8 やってみた ① 導入編

vRealize Automation 8 やってみた ② クイックスタート編

vRealize Automation 8 やってみた③ クラウドアカウントの登録

vRealize Automation 8 やってみた④ Cloud Zones or Virtual Private Zones

vRealize Automation 8 やってみた⑤ タグの設定

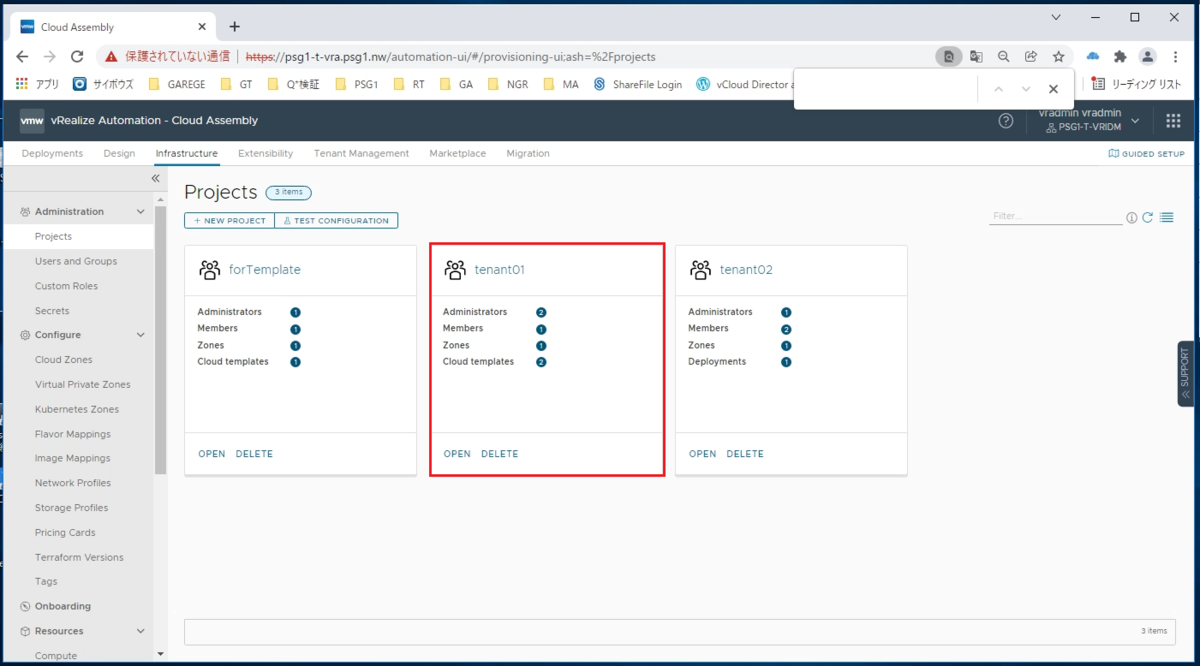

今回はプロジェクトを④で作成したVPZと紐づけるで作成します。

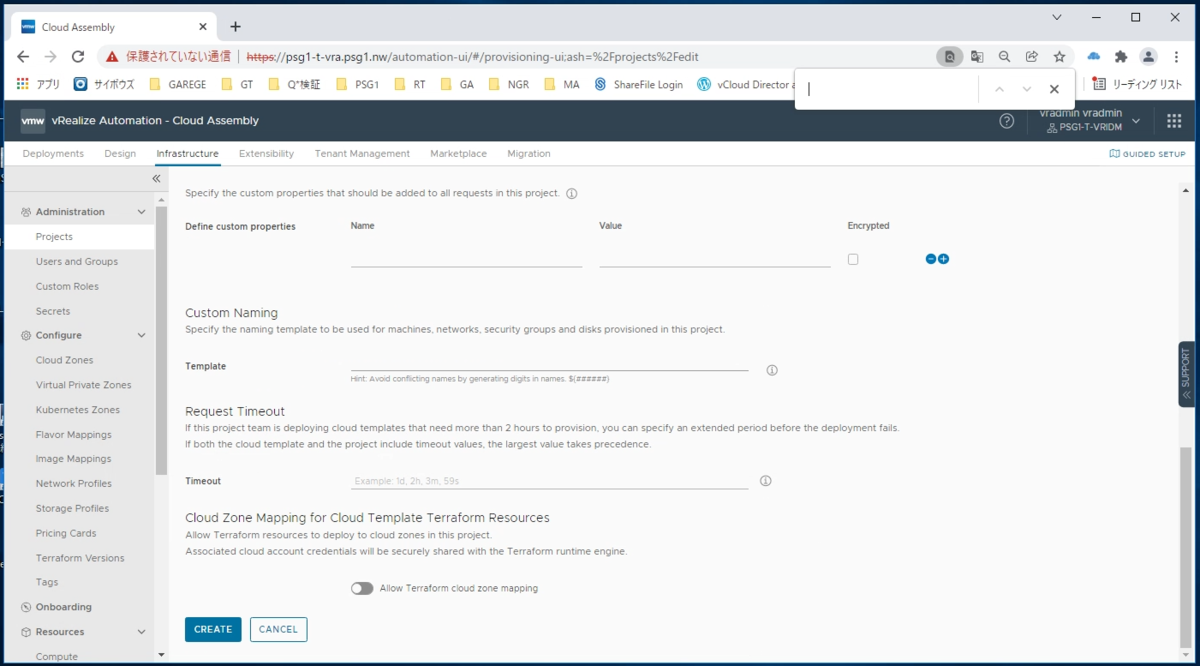

①[infrastructure]-[Projecs]-[NEW PROJECT]をクリックします。

②プロジェクトの名前を入力します。

③[Users]-[ADD USERS]をクリックします。

④ユーザを選択し、ロールを指定後[ADD]をクリックしてください。

⑤[Provisionig]-[ADD ZONE]-[Virtual Private Zone]をクリックします。

⑥利用するVPZを指定し[ADD]をクリックします。

割り当てメモリやCPUにリミットを掛ける場合はこの画面のリミットで設定します。

⑦[CREATE]をクリックします。

⑧プロジェクトが払い出されました。

次回はこちら

vRealize Automation 8 やってみた⑤ タグの設定

前回まではこちら

vRealize Automation 8 やってみた ① 導入編

vRealize Automation 8 やってみた ② クイックスタート編

vRealize Automation 8 やってみた③ クラウドアカウントの登録

vRealize Automation 8 やってみた④ Cloud Zones or Virtual Private Zones

前回はVPZの設定を施した為、任意のVPZで利用可能なリソースプールの指定、データストアの指定、利用可能なネットワークの指定まで設定を施しました。

今回はタグの設定を施します。色々な場面で活躍しますが今回はブループリント上でタグを利用してポートグループを指定する形で利用する為に、事前にタグを作成します。

①[infrastructure]-[Tags]-[NEW TAGS]をクリックします。

※すでにNetworkタグが二つ登録されていますが、同様の形でVLAN165を登録します。

②任意でKey/valueを入力し、[CREATE]をクリックします。

※今回は後で混乱しない様にNetworkのVLAN165(ポートグループ名)という形で設定してます。

③VLAN165用のタグが用意されました。

次回はこちら

vRealize Automation 8 やってみた④ Cloud Zones or Virtual Private Zones

前回まではこちら

vRealize Automation 8 やってみた ① 導入編

vRealize Automation 8 やってみた ② クイックスタート編

vRealize Automation 8 やってみた③ クラウドアカウントの登録

前回クラウドアカウントを設定しvRA8でvCenterが利用可能になりました。

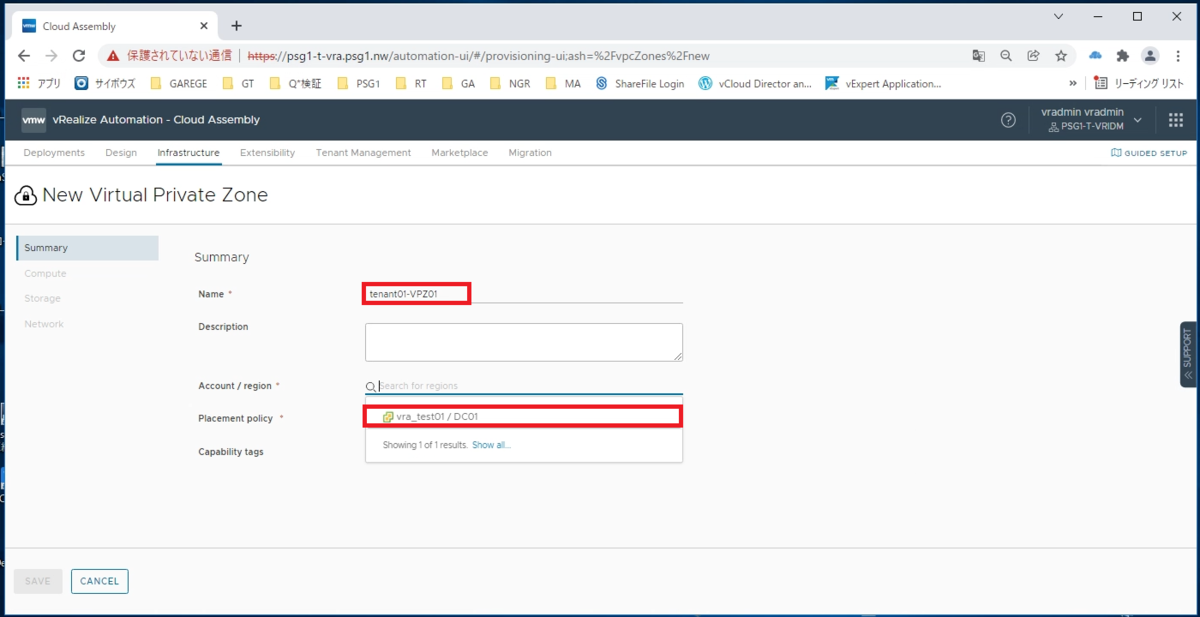

今回はCloud Zone or Virtual Private Zone(以下VPZ)の作成を行います。

Cloud ZoneやVPZですが、どちらもProject(テナント or システム)が利用できるvSphereリソースを抽象化した単位だと理解してください。

Cloud Zoneに関してはvCenter配下のDCに対して1対1で紐づきますが、VPZに関してはvCenter配下のリソースプールに直接紐づける事が可能な為、Project単位でリソースプールを作成し、VPZと紐づけてあげるのが運用しやすいUSECASEになると思います。

ですので今回はVPZを作成する手順として進めます。

①[Infrastructure]-[Virtual Private Zones]-[NEW VIRTULA PRIVATE ZONE]をクリックします。

②nameを[任意で入力]し、account/regionから[利用するvCenterのDC]を選択します。

③[Compute]-[Manually select compute]をクリックします。

④[ADD]をクリックします。

⑤利用可能に設定するResource Poolを設定し[ADD]をクリックします。

⑥作成中のVPZで利用可能なリソースプールが一つ選択された状態になりました。

VPZとprojectを1対1で設定する場合はそのprojectで利用するVMが全て該当のリソースプールに配置される事になります。

⑦[Storage]-[Datastore/cluster]から利用させたいデータストアを選択します。

⑧[Network]-[ADD NETWORK]をクリックします。

⑨利用可能にさせたいポートグループを選択し[ADD]をクリックします。

⑩[SAVE]をクリックします。

⑪リソースプール、ストレージ、ネットワークを各一つづつもっているVPZが払い出されました。

次回はこちら

vRealize Automation 8 やってみた③ クラウドアカウントの登録

前回まではこちら

vRealize Automation 8 やってみた ① 導入編

vRealize Automation 8 やってみた ② クイックスタート編

vRA8実装時、導入からクイックスタートを行ってみましたが、

その後あまり触っておらずに早2年が経ちました。

vRAは8.6までリリースされており、承認機能等vRA8で無くなった昨日が復活している為

改めてvRA8を触ってみようと思います。

まずはクラウドアカウントとしてローカルのvCenterをエンドポイントとして利用できるように設定を行います。

①システム管理者ユーザでログインし、[Cloud Assembly]をクリックします。

Cloud Assembly:インフラ設定やブループリント

Service Broker:ユーザーポータル

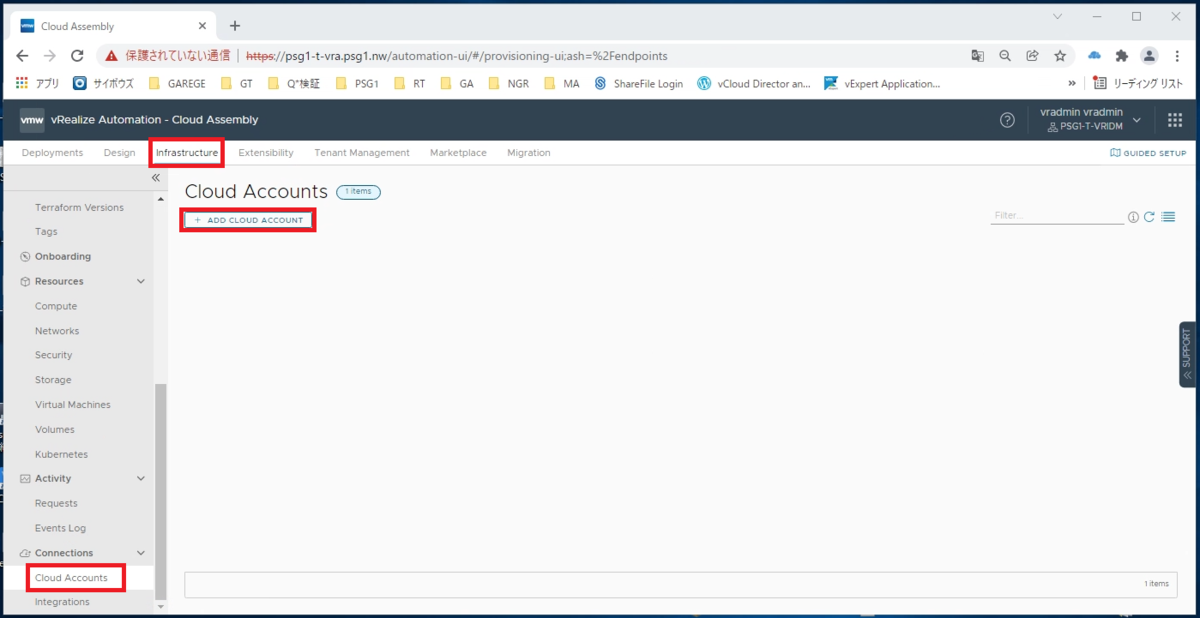

②[infrastructer]-[Cloud Accounts]-[ADD CLOUD ACCOUNT]をクリックします。

③[vCenter]をクリックします。

④[name][vCenter IP or fqdn][username/password]を入力し、[VALIDATE]をクリックします。

⑤[ACCEPT]をクリックします。

⑥[Credentials validated successfully]が表示された事を確認後、利用するDCに☑を入れ[ADD]をクリックします。

※Create a cloud zone for the selected datacentersの☑は外します。☑を入れた場合はデフォルトで1つ作成されますが、次回手動で設定します。

⑦vCenterオブジェクトのCloud Accountsが作成されました。

登録対象のvCenterをエンドポイントとして利用可能になりました。

次回はこちら

VMware Cloud Director 高可用性構成 フェイルオーバモードの変更方法

VMware Cloud Director のアプライアンスが実装されてからは高可用性モードが利用可能になっておりますが、10.1以降ではプライマリ データベース サービスに障害が発生した場合、自動フェイルオーバーを実行できます。

現在はGUIでは実行できずAPIを利用する必要がある為、設定方法をご紹介します。

①まずはデフォルトのフェイルオーバモードの確認です。

Failover Modeはマニュアルに設定されています。vCDデータベースに障害が発生した場合は手動でSWITCHOVERを行わなければ自動フェイルオーバが行われません。

②フェイルオーバーモードをAutomaticに変更します。

②フェイルオーバーモードをAutomaticに変更します。

筆者はPOSTMANを利用して実行しております。

POSTモードに変更後以下のコマンドをタイプします。

https://vcdfqdn:5480/api/1.0.0/nodes/failover/automatic

③続いて認証情報の入力前に、SSL証明書を差し替えていない場合は以下を実行してください。

[Settings]-[Enable SSL certicicate verificationをオフ]

④[aurthorizationタブ]-[Basic Auth]-[アカウントパスワードの入力]-[Send]をクリックします。

⑤Failover ModeがAUTOMATICに変更されました。

⑥api上からステータスを確認する場合は[params]-[Headers]-[Lcation]の値をコピーします。

⑦コピーした値をGETすると、Massageから以下のメッセージが確認できます。

Daemon operation completed successfully on all nodes

VMware Cloud Director採用時のテナントネットワーク構成 ③ Tier1 GWをテナント管理者が作成可能にする方法

前回までの記事は下記です。

VMware Cloud Director採用時のテナントネットワーク構成① (NSX for vSphere NSX-T比較)

VMware Cloud Director採用時のテナントネットワーク構成② (T0,T1 router構成)

NSX-V環境ではテナント管理者にデフォルトでEdgeGWの作成権限を割り当て可能でしたが、NSX-T環境ではデフォルト設定ではテナント管理者でのTier-1GWの作成が行えません。

設定可能にする為にはグローバル権限としてテナント管理者に対して権限を付与する必要があります。

システム管理者権限でプロバイダUIにログインし、[管理]-[グローバルロール]-[編集]-[組織管理者]-[編集]をクリックします。

ゲートウェイの作成やゲートウェイの削除等に☑を入れて保存を行うと、各テナントの組織管理者ロールに権限付与画面が表示されるようになります。